Test • Zen 5 vs Arrow Lake-S : 9800X3D, Core Ultra 285K, 265K et 245K |

————— 20 Novembre 2024

Test • Zen 5 vs Arrow Lake-S : 9800X3D, Core Ultra 285K, 265K et 245K |

————— 20 Novembre 2024

Certaines cartes mères ayant la fâcheuse tendance de router une partie de l'énergie consommée par le CPU via le 24pins, nous réinstaurons les mesures de consommation à la prise. Il faut toutefois nuancer celles-ci puisqu'elles représentent la consommation totale de la configuration (sans GPU), y compris le rendement de l'alimentation. Nous intègrerons à l'avenir une mesure sur le 12V du 24 pins également. Nous avons également conservé le relevé sur le rail CPU 12V, car il permet certaines comparaisons pertinentes. Notez toutefois que la consommation relevée ici concerne une valeur typique (moyenne sur une minute après 9 minutes d'activité), mais il y aura naturellement des pics réguliers dans un sens ou dans l'autre.

Les améliorations apportées par Intel à sa nouvelle architecture sont claires, puisque le nouveau fleuron, l'Ultra 9 285K, affiche une réduction de 50% par rapport au 14900K. Alors oui, ça n'était pas bien compliqué de faire mieux que ce four digne des Pentium d'antan, mais quand même, le fondeur de Santa Clara amorce un pas dans la bonne direction. Des économies d'énergie qui se propagent sur toute la gamme.

Pour ce qui est du 9800X3D, le passage à une fréquence de base plus élevée fait exploser la consommation lorsqu'il est fortement sollicité. Mais finalement, cela se traduit également par des performances en hausse, de sorte que nous considérons encore cette modification comme une amélioration. Ce d'autant plus qu'au repos ou lors de faibles sollicitations, la puce se montre tout aussi frugale que le 7800X3D. AMD montre une fois encore que son architecture Zen 5 propose le meilleur compromis performance/consommation actuel.

Il est assez drôle de constater que malgré 2 approches très différentes, tant AMD qu'Intel ont réussi a faire baisser la température de leurs CPU, et ce alors que chez AMD, la consommation a augmenté de près de 50%.

Ceci s'explique par le changement de position entre le CCD (la partie du die qui embarque tous les cores et le cache) et les 64 Mo de cache supplémentaire. Auparavant, ce dernier élément était placé par-dessus le premier, de sorte qu'il devenait un obstacle à la dissipation thermique. Désormais, cette partie fait office de base pour le CCD, qui se retrouve donc au-dessus, au plus proche du heatspreader et donc du cooling CPU. Cela se ressent immédiatement sur les températures de fonctionnement, et c'est d'ailleurs ce point qui a permis à AMD d'augmenter les fréquences de base. En pratique, et avec exactement le même refroidissement, on passe de 75,4 à 81,4 °C. Une augmentation de température, oui, mais qui se traduit également par un gain de 27% des performances applicatives. En comparaison, notre 9700X se contentait de 53,4°C !

Pour ce qui est des Arrow Lake, la baisse drastique de la consommation permet de revenir dans des limites plus tolérables. L'Ultra 7 265K se contente de 84°C en charge prolongée sous Cinebench 2024 avec un D15 G2 (à fond). En comparaison et dans les mêmes conditions, l'î7-14700K file vers les 90°C en quelques secondes et s'y accroche ensuite comme une moule à son rocher avec une température maximale de 97°C. Et ce alors que les performances dans ce test sont inférieures d'environ 8%.

Grosse nouveauté sur le 9800X3D, il est possible de l'overclocker. C'est le gros avantage de virer la couche de cache 3D des CCD : ils sont mieux refroidis et on obtient une bien meilleure montée en fréquence. En pratique, vous pouvez donc tout à fait régler votre overclocking comme ça vous chante, mais pas de quoi casser 3 pattes à un canard. En effet, comme souvent avec les CPU modernes, il est compliqué d'atteindre manuellement le même niveau d'optimisation. Il est possible d'obtenir à peu près les mêmes fréquences qu'en Boost maximal, mais au-delà, impossible de stabiliser le CPU. Une utilité toute relative donc, et le tout pour une consommation et une chauffe supérieure au mode par défaut lorsqu'on ne tire pas à 100% dans les cores. En effet, le BIOS de notre Crosshair X870E Hero n'autorisait pas d'offset positif de la courbe de tension, seulement négatif. Il devenait donc obligatoire de passer par une tension fixe pour atteindre les fréquences visées.

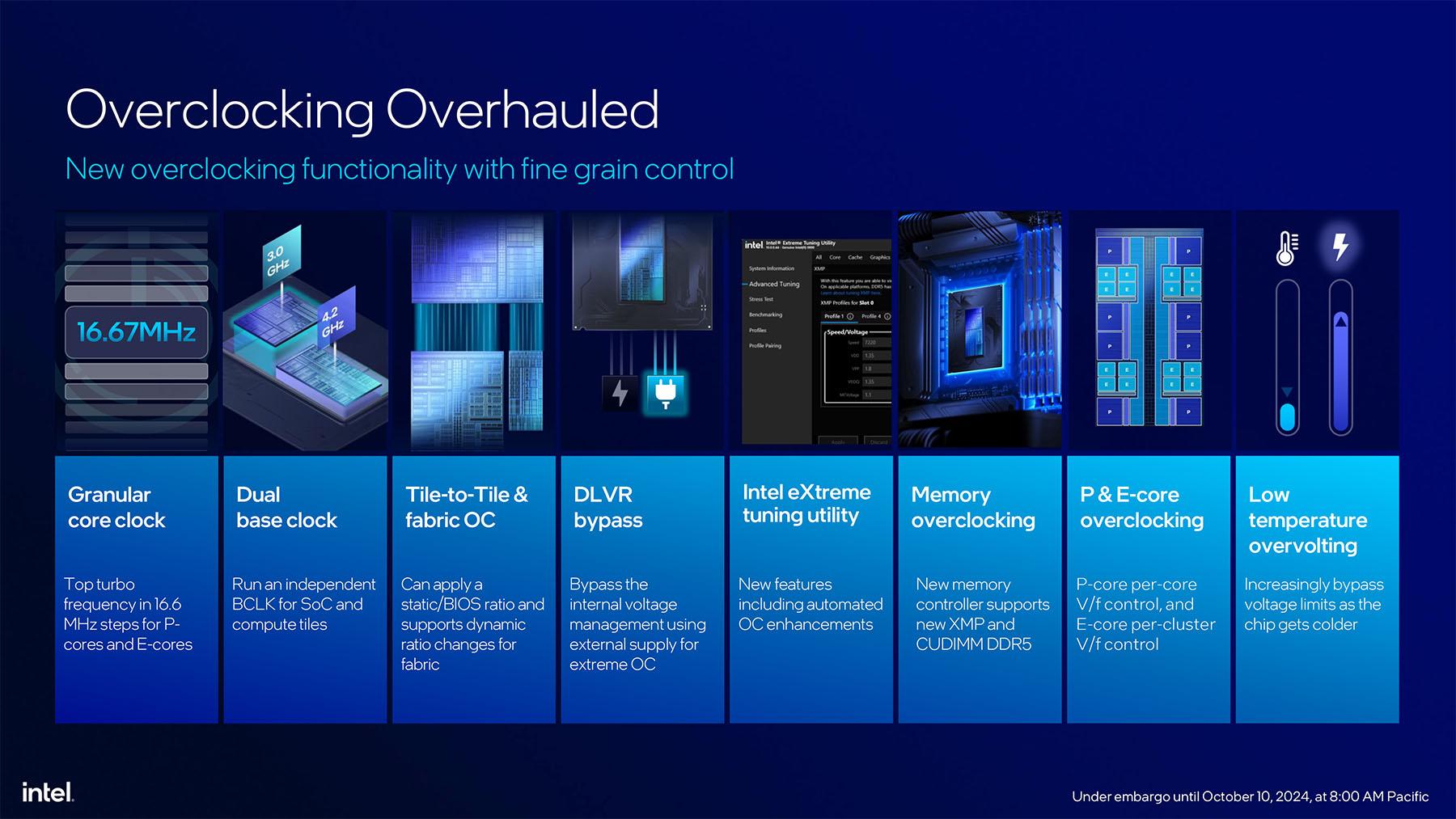

Chez Intel, la plateforme Arrow Lake-S apporte de nombreux changements, à commencer par un pas de 16 MHz pour l'ajustement de la fréquence CPU. Mais en réalité, c'est surtout utile à Intel afin de grappiller chaque dixième de MHz partout où c'est possible. Mais pour un overclocking quotidien, pouvoir stabiliser 5433 MHz ou 5400 MHz ne change finalement pas grand-chose. Et comme chez AMD, il est possible d'atteindre les fréquences maximales du Turbo Boost multicore, mais pas vraiment plus. Ça pourrait se révéler utile pour verrouiller des fréquences multicore prolongées, mais on y perd du côté des usages 1 ou 2 cores. L'overclocking séparé des E-cores est également de la partie, mais là encore, Intel a bien travaillé sa copie et il n'était pas possible de stabiliser le 285K au-delà des 4600 MHz d'usine.

Acronyme de Digital Linear Voltage Regulator, cette nouveauté sur Arrow Lake autorise l'activation, via un composant interne au package processeur, d'un canal d'alimentation auxiliaire destiné à lisser les variations de courants, ou courants transitoires, ayant notamment lieu lors des variations brutales des besoins énergétiques — le fait de passer d'idle à 50 % de charge par exemple. Le principe est similaire à l'application d'un Vdroop bien connu de ceux qui aiment tripoter leur BIOS, à la différence que le DLVR est appliqué en fonction des besoins, et non pas en continu, impliquant dès lors un bien meilleur rendement et par la même une baisse de consommation lorsque non sollicité.

En cas d'overclocking, le DVLR se retrouve néanmoins moins intéressant par un rendement trop faible : il est ainsi possible de le désactiver en activant le Power Galting Mode pour favoriser les montées en fréquence. Du moins, il était possible, car Intel à vérouillé la chose avec le microcode 0x112 le rendant désormais éventuellement accessible aux tréfonds des options avancées d'OC des BIOS des cartes maman spécialisées dans cette activité, devenue plus ou moins inutile depuis pas mal de générations maintenant.

|

|

| Un poil avant ?Windows 365 Link, le mini-PC exclusivement cloud de Microsoft | Un peu plus tard ...Le marché des processeurs reprend du poil du CPU |  |

| 1 • Préambule |

| 2 • Arrow Lake-S en détail |

| 3 • Le 9800X3D, plus qu'une redite |

| 4 • Jeu de chips et chaussettes |

| 5 • Protocole de test |

| 6 • Performances ludiques |

| 7 • Performances applicatives |

| 8 • |

| 9 • Verdict(s) |