Test • Zen 5 vs Arrow Lake-S : 9800X3D, Core Ultra 285K, 265K et 245K |

————— 20 Novembre 2024

Test • Zen 5 vs Arrow Lake-S : 9800X3D, Core Ultra 285K, 265K et 245K |

————— 20 Novembre 2024

Arrow Lake, c'est un peu un méli-mélo de plein de trucs. Intel a fait feu de tout bois pour tenter non seulement de contrer AMD, a qui tout semble sourire ces temps-ci, au moins côté CPU, mais aussi pour répondre aux problématiques soulevées par ses clients, dont l'efficacité énergétique.

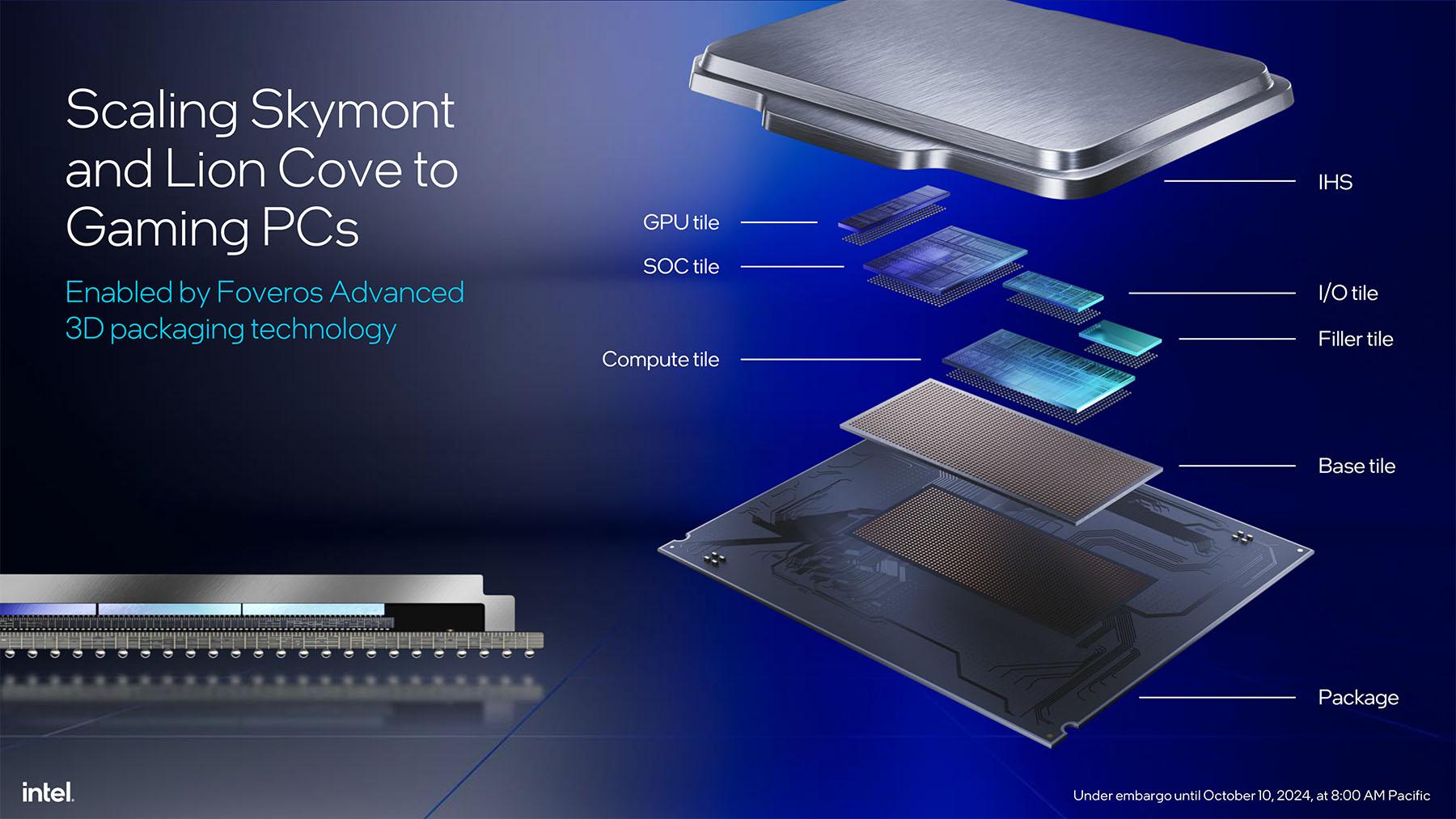

La marque inaugure aussi le principe de tiles, c'est-à-dire des bouts de die tous rassemblés sur une base tile. Une approche similaire dans l'idée à celle d'AMD et de ses chiplets. D'une part, cela réduit la complexité de chaque tuile — tout est relatif hein ! — et ainsi le taux de rebuts. Mais surtout, cela permet de designer et graver chaque tuile selon des contraintes très différentes. Certains process sont en effet plus adaptés à l'efficacité énergétique, d'autres à la montée en fréquence, etc. Ici, la tuile des Compute — les cores quoi — est gravée en N3b chez...TSMC. Non, vous n'avez pas la berlue. L'excuse invoquée : "on a pioché le process le plus adapté à nos besoins". Ou une tendre façon de dire qu'Intel rame sévère et qu'il est temps de se secouer les plumes. Mais bon, pour le consommateur, c'est plutôt une bonne nouvelle effectivement. L'IGP est gravé en N5p, et les tuiles SoC et IO en N6. Tout ça prend place sur une "3D base tile" d'origine Foveros.

Les plus attentifs auront remarqué une "filler tile". Rien à voir avec le métier de carrossier, mais ça s'en rapproche : il s'agit simplement d'un machin qui sert à supporter les tuiles supérieures, histoire de bâtir sur des fondations solides.

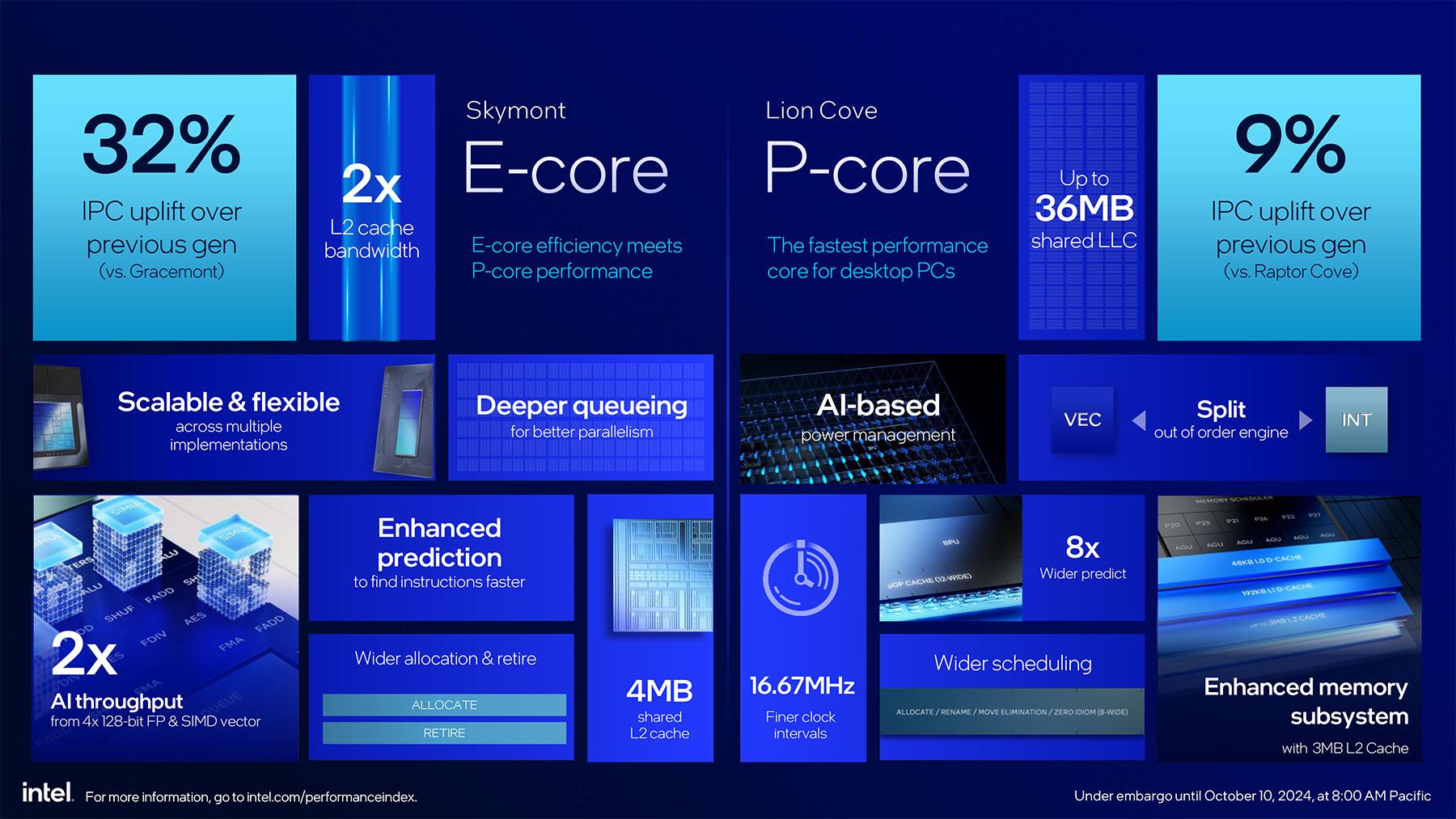

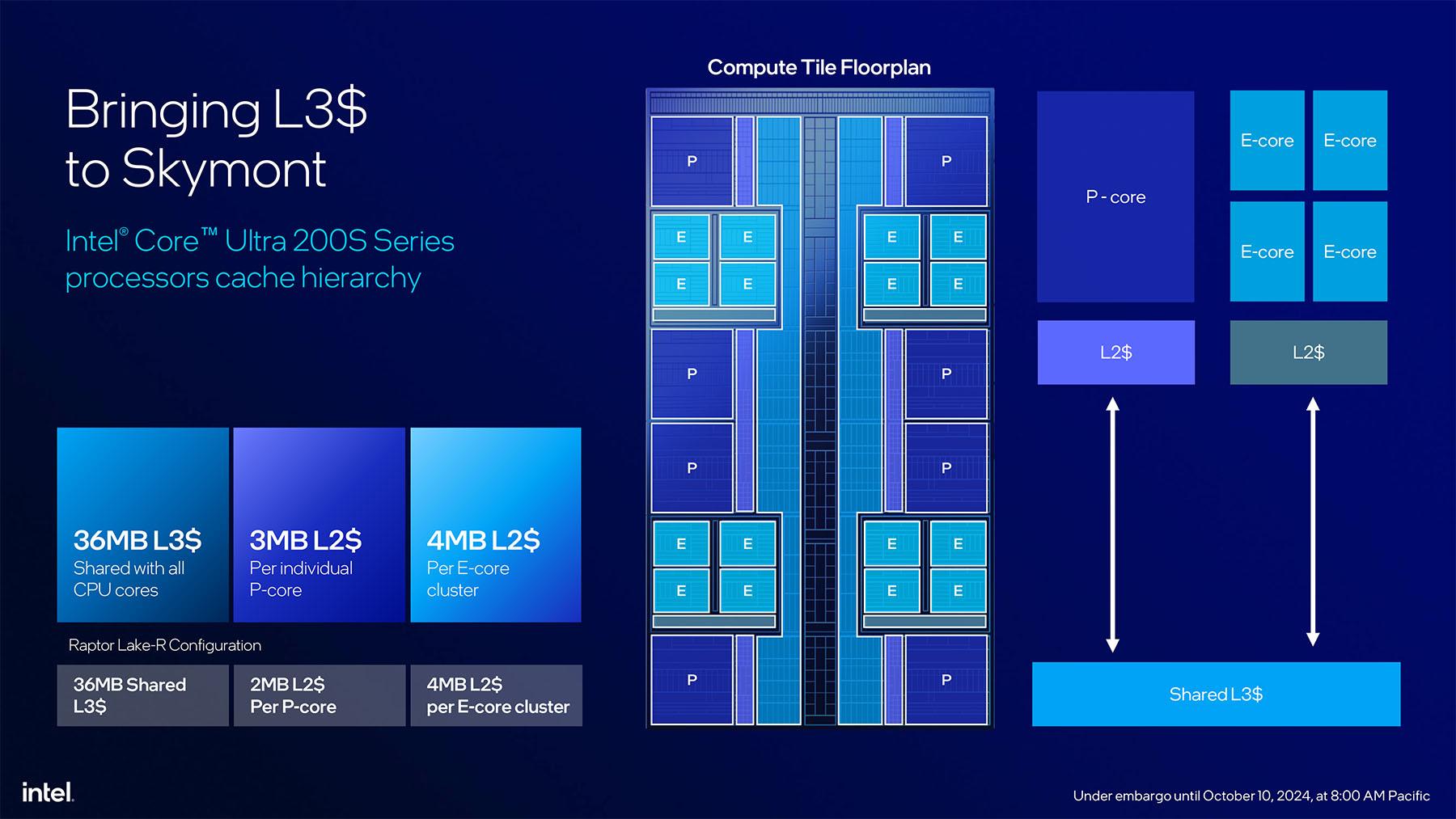

Au niveau des E-cores, on retrouve l'architecture Skymont déjà aperçue sur Lunar Lake. Nous vous invitons à lire notre article dédié puisqu'à ce niveau rien de fondamental ne change, et ceux-ci se montrent toujours plus rapides à consommation équivalente, et Intel annonce un gain d'IPC de 32% face aux Gracemont des Core 14th gen. Pour Arrow Lake, Intel a repris le cluster de 4 E-cores de Lunar Lake, ainsi que ses 4 Mo de L2 dédié, mais a disséminé un total de 4 clusters sur le die des nouveaux CPU. Soit un total, au maximum, de 16 E-cores.

Fait intéressant, ces E-cores ne vivent pas dans un terrier tous ensemble, mais se retrouvent disséminés un peu partout telles des chaussettes sales une fin de semaine. Intel a effectivement calé ces clusters entre 2 P-cores afin de dispatcher les points chauds du CPU sur une plus grande surface et ainsi améliorer la dissipation thermique. Notez également que comme pour Lunar Lake, Intel attribue toujours un nouveau thread aux E-cores en premier. Ceux-ci se voient remplacés par un P-core si le besoin s'en fait sentir via Thread Director. Une bonne approche pour la consommation, et qui se justifiait tout à fait du point de vue mobile avec Lunar Lake, mais qui n'est pas forcément la meilleure approche pour les PC de bureau. Gageons que là aussi, Intel saura intégrer des bypass pour certains cas d'usage.

Pour ce qui est des P-cores, c'est la microarchitecture Lion Cove qui est aux manettes, elle aussi déjà vue sur Lunar Lake il y a quelques mois. Et la grosse nouveauté ici concerne la disparition de l'HyperThreading ! "Fuis-moi, je te suis. Suis-moi, je te fuis." Pour rappel, ce changement révolutionnaire s'explique par l'hybridation, depuis la 12e génération (2022). L’HyperThreading n’étant activé que lorsque tous les cores — P et E — sont sollicités, le gain restait finalement assez minime pour un PC grand public. S’il offrait 20% de performances supplémentaires à fréquence et tension identiques, c’était au prix d’un encombrement plus important et uniquement pour certains cas de figure. Ainsi, en se débarrassant de tous les transistors qui avaient trait à l’HyperThreading, Intel annonce un ratio performance/puissance en hausse de 5% en multithreading, et une hausse de 15% du ratio performance / puissance / surface. Le compromis performance / surface est le seul qui régresse, de 15%.

En passant de Raptor Lake Refresh à Arrow Lake, Intel annonce 9% d'IPC supplémentaires sur les P-Cores. Finalement, sur une génération, c'est plutôt satisfaisant, mais il ne faut pas oublier certains détails. À commencer par le fait que le 285K accuse tout de même un déficit de 300 MHz sur le 14900K, soit une baisse de 5% qui viendra en partie rogner sur ce gain d'IPC. Bien sûr, le corollaire est envisageable sur les fréquences de base, qui sont à l'avantage des Arrow Lake, mais il ne faut pas oublier que les processeurs modernes fonctionnent rarement à leur fréquence de base. Quoi qu'il en soit, en plus de cet aspect, Arrow Lake se voit privé d'HyperThreading, alors que celui apportait un gain qui pouvait atteindre 20%.

Bien sûr, ceci ne concerne que les usages multithreadées, mais ceci montre que le gain d'IPC ne fait clairement pas tout. Nous verrons en pratique comment se comportent ces Ultra 200, mais Intel annonce un gain en multithread de 15%, donc il y a de l'espoir.

![Cliquédélique ! intel lunar lake lion cove hyperthreading multi t [cliquer pour agrandir]](/images/stories/_cpu/5nm-20a_intel/lunar-lake/intel-lunar-lake-lion-cove-hyperthreading-multi_t.jpg)

![3N C11QU4N7 C357 P1U5 6r4ND intel lunar lake lion cove hyperthreading single t [cliquer pour agrandir]](/images/stories/_cpu/5nm-20a_intel/lunar-lake/intel-lunar-lake-lion-cove-hyperthreading-single_t.jpg)

Alors, comment atteindre ces 9% supplémentaires ? Comme souvent chez Intel, on rajoute du cache, 3 Mo par P-core au lieu de 2 Mo précédemment. Tous les cores, E-cores y compris, sont arrangés autour d'un ring bus qui assure la liaison inter-cores et avec le L3 de 36 Mo (inchangé). Ce n'est pas le seul changement puisqu'Intel a également ajouté un nouveau cache entre les L2 et L1. Celui-ci se nomme L1D et compte 192 Ko avec une latence de 9 cycles, le L1 étant pour l'occasion renommée L0D, mais stagne à 48 Ko et 4 cycles.

![Même pas cap' de cliquer intel lunar lake lion cove t [cliquer pour agrandir]](/images/stories/_cpu/5nm-20a_intel/lunar-lake/intel-lunar-lake-lion-cove_t.jpg)

Un P-core d'Arrow Lake en détail.

Le cache pour les micro-ops est lui aussi augmenté et passe de 6 à 8. Intel introduit d'ailleurs la notion de nano-ops, des micro-ops similaires qui peuvent être appairés et exécutés en tandem.

L'exécution out-of-order se voit partitionnée entre le traitement des entiers (INT) et des vecteurs (VEC) des aspects integer et vector sont désormais séparés, chacun disposant désormais de son propre scheduler. La séparation n'apporte pas forcément de gain de performance en elle-même, mais permet de mieux adapter le CPU aux besoins modernes, ou en tout cas l'interprétation qu'en fait Intel, et de réduire la consommation selon le type d'utilisation via des unités spécialisées. Ce qui se traduit directement par une refonte des ports d'exécution : si l'on passe de 12 à 18 ALU, on passe surtout de 5 à 6 unités pour les entiers, et de 3 à 4 ALU pour le vectoriel.

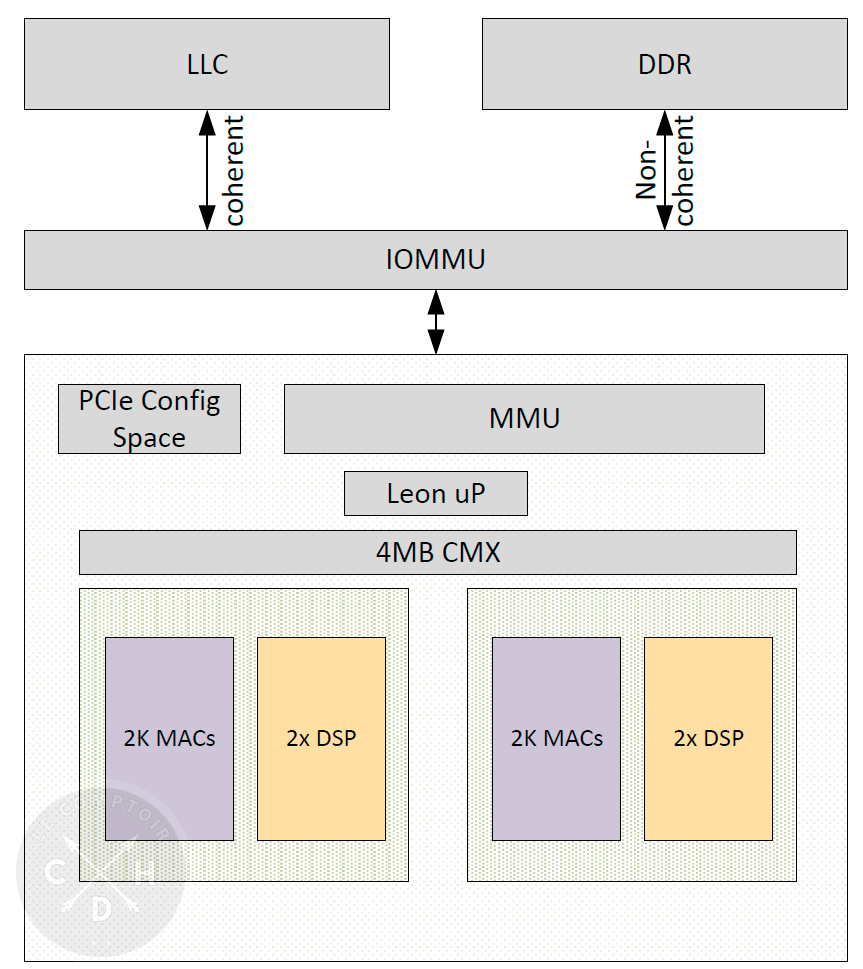

Arrow Lake, ce ne sont pas que des cores. Il s'agit aussi d'un NPU (Neural Processing Unit), soit un truc qui s'occupe de gérer les besoins IA du système. Il s'agit ici du même NPU que sur Meteor Lake, l'ancienne architecture mobile Intel. Pourquoi se contenter d'un vieux machin alors que Lunar Lake a justement intégré un NPU tout beau tout neuf ? D'après Intel, ce n'était pas le focus pour Arrow Lake. La partie compute et IGP aurait primé. Pourquoi pas après tout, mais c'est un peu fort en chocolat de se dire que le fleuron grand public d'Intel, le 285K, ne pourra pas profiter du label Copilot+.

Le diagramme logique du NPU

L'IGP pour sa part est divisé entre la tuile graphique, qui contient les unités d'exécution, tandis que la tuile SoC embarque tout ce qui a trait à l'affichage et aux IO. Ici, Intel s'appuie sur l'architecture Xe-LPG, déjà vue dans Meteor Lake et il s'agit d'une légère upgrade par rapport au Xe-LP de Raptor Lake avec, cette fois, le support de DirectX12 Ultimate. La différence : le support du ray tracing via 4 unités RT, 1 par Xe-core. En revanche, contrairement à l'architecture Xe-HPG des GPU dédiés Arc Axxx, point d'accélérateur XMX, et donc pas de traitements IA dans le GPU, tout cet aspect est exclusivement traité par le NPU. Nous reviendrons potentiellement plus en détail sur les performances de cet IGP dans un futur article ou complément.

| Processeur | Configuration | Fréquence P-core (max/base) | Fréquence E-core (max/base) | L1/core L2/core L3 | TDP | tarif |

|---|---|---|---|---|---|---|

| Core Ultra 9 285K | 24C / 24T (8P+16E) | 5,7 / 3,7 GHz | 4,6 / 3,2 GHz | 240 Ko 3 Mo (P) 36 Mo |

125W | 589 $ |

| Core Ultra 7 265K | 20C / 20T (8P+12E) | 5,5 / 3,9 GHz | 4,6 / 3,2 GHz | 240 Ko 3 Mo (P) 36 Mo |

125W | 394 $ |

| Core Ultra 7 265KF | 20C / 20T (8P+12E) | 5,5 / 3,9 GHz | 4,6 / 3,3 GHz | 240 Ko 3 Mo (P) 36 Mo |

125W | 379 $ |

| Core Ultra 5 245K | 14C / 14T (6P+8E) | 5,2 / 4,2 GHz | 4,6 / 3,3 GHz | 240 Ko 3 Mo (P) 36 Mo |

125W | 309 $ |

| Core Ultra 5 245KF | 14C / 14T (6P+8E) | 5,2 / 4,2 GHz | 4,6 / 3,6 GHz | 240 Ko 3 Mo (P) 36 Mo |

125W | 249 $ |

| Core i9-14900K | 24C / 32T (8P + 16E) |

6 / 3,2 GHz | 2,4 / 4,4 GHz | 80 Ko (P) 2 Mo (P) 36 Mo |

125W | 589 $ |

| Core i7-14700K | 20C / 28T (8P + 12E) |

3,4 / 5,6 GHz | 2,5 / 4,3 GHz | 80 Ko (P) 2 Mo (P) 33 Mo |

125W | 409 $ |

| Core i5-14600K | 14C / 20T (6P + 8E) |

5,3 / 3,5 GHz | 4 / 2,6 GHz | 80 Ko (P) 2 Mo (P) 36 Mo |

125W | 319 $ |

| Core i9-12900K | 24C / 24T (8P+8E) |

5,2 / 3,2 GHz | 3,9 / 2,4 GHz | 80 Ko (P) 1,25 Mo (P) 30 Mo |

125W | 648 $ |

| Core i7-12700K | 20C / 20T (8P + 4E) |

5 / 3,6 GHz | 3,8 / 2,7 GHz | 80 Ko (P) 1,25 Mo (P) 25 Mo |

125W | 450 $ |

| Core i5-12600K | 10C / 16T (6P + 4E) |

4,9 / 3,7 GHz | 3,6 / 2,8 GHz | 80 Ko (P) 1,25 Mo (P) 20 Mo |

125W | 318$ |

Intel se contente de 5 puces pour ce lancement, mais il n'y a finalement que 3 CPU différents, 2 d'entre eux étant déclinés en variante avec et sans IGP. Une gamme somme toute épurée, mais qui pourrait se voir complétée par d'autres processeurs dans le futur, comme indiqué ici.

Outre le 285K qui embarque le compte de cores maximum, à savoir 8 P-cores et 16 E-cores, le 265K se voit amputé de 4 E-cores (un par cluster). Le 245K pour sa part abandonne en prime 2 P-cores. De fait, l'offre actuelle est plutôt généreuse en nombre de cores. On s'étonne toutefois de ne pas voir apparaitre le moindre modèle quad core, qui aurait l'avantage de proposer un ticket d'entrée plus abordable. Il est probable que ce sera le cas dans un futur plus ou moins proche, mais que pour l'heure, Intel concentre ses efforts sur un unique die, et castrer celui-ci de la moitié de ses cores n'aurait pas beaucoup d'intérêt. Et ce d'autant plus que le rendement ne doit pas être si mauvais grâce a l'utilisation des tuiles.

Les fréquences sont assez classiques, avec un Turbo max au-delà de 5 GHz pour tout le monde. Sans surprise, et malgré un TDP identique pour toutes les puces, l'Ultra 5 est celui qui profite du Turbo le moins élevé. Afin de compenser ce point, la puce profite en revanche de la plus haute fréquence de base, au-delà des 4 GHz.

|

|

| Un poil avant ?Windows 365 Link, le mini-PC exclusivement cloud de Microsoft | Un peu plus tard ...Le marché des processeurs reprend du poil du CPU |  |