Libérer le potentiel des SSD QLC à l'aide de FDP, c’est le projet de DapuStor (MAJ) |

————— 02 Août 2024 à 13h21 —— 25109 vues

Libérer le potentiel des SSD QLC à l'aide de FDP, c’est le projet de DapuStor (MAJ) |

————— 02 Août 2024 à 13h21 —— 25109 vues

Mise à jour 03/08

Comme deux d’entre vous l’ont noté en commentaire, cette technologie FDP n’est pas propriétaire ou exclusive à DapuStor. Peut-être trop emballés par la volonté de colporter ce projet au point d’en devenir godillots, nous avons commis une erreur d’appréciation.

Mea-culpa donc : le FDP (Flexible Data Placement) s’apparente en fait à une évolution du ZNS (Zoned Name Space). C’est une technologie qui joue sur le facteur d'amplification d'écriture (WAF) en introduisant le facteur de Reclaim Unit.

Surtout, le consortium NVM Express a travaillé à l'ajout du FDP au jeu de commandes NVMe. L’initiative a notamment été encouragée par l'Open Compute Project de Meta et par Google, afin que les hyperscalers qui possèdent des milliers de SSD bénéficient d’une durée de vie accrue et conservent leur réactivité au fur et à mesure que ces disques vieillissent.

Ce procédé a été décrit à l’occasion de l’OCP Global Summit 2022 dans la vidéo ci-dessous publiée par le chaîne Open Compute Project.

Vous pouvez également accéder à une présentation d’une quinzaine de pages réalisée par Ross Stenfort, membre de Meta, à cette adresse. ET rendons à César ce qui est à César : ces deux documents ont été cités par Block & Files dans un article daté d'août 2023.

Vous l’aurez compris, DapuStor ne fait donc qu’exploiter ce concept. D’ailleurs, Samsung a aussi publié il y a trois jours un document titré Flexible Data Placement. Nous pouvons y lire dès l’introduction que de « nombreux produits SSD de Samsung prennent désormais en charge le placement flexible des données (FDP), un moyen d'optimiser le fonctionnement du disque en prenant en compte les directives de placement de l'hôte ».

À l’instar de la page de DapuStor, celle de sa concurrente décrit le principe de fonctionnement du FPD. Elle se termine par la même conclusion : « Le placement flexible des données est un moyen économique, facile à mettre en œuvre et à utiliser pour réduire la consommation d'énergie des disques SSD, atténuer les problèmes de surchauffe et augmenter la durée de vie des disques en minimisant le WAF ».

Afin de quantifier les bénéfices, Samsung met pour sa part l’accent sur la baisse de la consommation. L’entreprise précise que pour un SSD de 4 ou 8 To avec des vitesses de lecture / écriture séquentielles de respectivement 10 700 Mo/s et 5,500 Mo/s , le FDP induit une réduction de 43,6 % de la consommation d'énergie.

Bref, ce qui suit reste valable ; gardez simplement à l’esprit que DapuStor n’a aucune exclusivité à faire valoir.

Article original du 02-08

DapuStor Corporation — le nom de cette entreprise ne vous dit peut-être rien, mais elle se présente comme une experte en matière de SSD d’entreprise. La société vient d’annoncer un partenariat avec Marvell autour de l'implémentation de la technologie FDP pour le contrôleur Marvell Bravera SC5 (un contrôleur PCIe 5.0). Et non, dans le cas présent, il ne s’agit pas du terme scientifique utilisé pour exposer une ascendance maternelle péripatéticienne, mais juste du sigle de Flexible Data Placement.

Entre cette illustration et celle de la mémoire NOR, CDH risque d'être catalogué macroniste ; pourtant, ce n'est pas notre projet !

Vous le savez, et comme l’explicite DapuStor dans son communiqué, en raison de leur capacité à stocker quatre bits de données par cellule de mémoire (d’où leur nom), les SSD QLC (Quad-Level Cell) offrent des avantages en termes de capacité et de coût total de possession. En contrepartie, leur endurance et leurs vitesses d’écriture ne sont pas extraordinaires – pour faire une analogie JO-iesque, dans un 800m nage libre, ils s’essouffleraient et couleraient au fond de la piscine au bout de quelques longueurs de bassin.

En exploitant FPD, DapuStor Corporation souhaite donner un second souffle aux disques Marvell. L’entreprise se met au défi de « relever les défis inhérents aux disques SSD QLC, en améliorant leurs performances, leur endurance et leur capacité »; ce, afin de proposer « une solution robuste et rentable pour les centres de données, l'informatique en nuage et les environnements informatiques à haute performance ».

Pour devenir des bêtes de course, les SSD QLC réagissent moins bien que les athlètes au trimétazidine ou au clenbutérol. Pour les disques, la potion magique pour booster leurs performances est FDP, une technologie gérée au niveau du micrologiciel.

Dans son communiqué, la société décrit le procédé ainsi :

« La technologie FDP répartit intelligemment les données sur la mémoire Flash QLC, en optimisant l'utilisation des cellules de mémoire disponibles et en minimisant l'impact de l'amplification de l'écriture. Les algorithmes FDP ajustent dynamiquement le placement des données en fonction de la charge de travail et des schémas d'utilisation, en veillant à ce que les données les plus fréquemment consultées soient stockées dans les régions les plus rapides et les plus durables du SSD. Il en résulte des performances améliorées, une endurance prolongée et une fiabilité accrue. »

Outre le placement intelligent des données, la DapuStor ajoute que le FDP intègre des techniques avancées de correction des erreurs et de nivellement de l'usure, ce qui améliore encore l'endurance et la fiabilité des SSD QLC.

Tous ces mécanismes contribuent à « des vitesses d'écriture plus élevées, une latence plus faible et une durée de vie plus longue ». La société ajoute que des tests internes des algorithmes FDP intégrés au contrôleur SSD Bravera SC5 de Marvell et au micrologiciel DapuStor aboutissent à une amplification d'écriture (WAF, write amplification factor) proche de 1,0 (une WAF de 1,0 indique que le SSD utilise la NAND flash à son plein potentiel d'endurance sans gaspillage).

Des détails supplémentaires sont disponibles sur le site web de DapuStor.

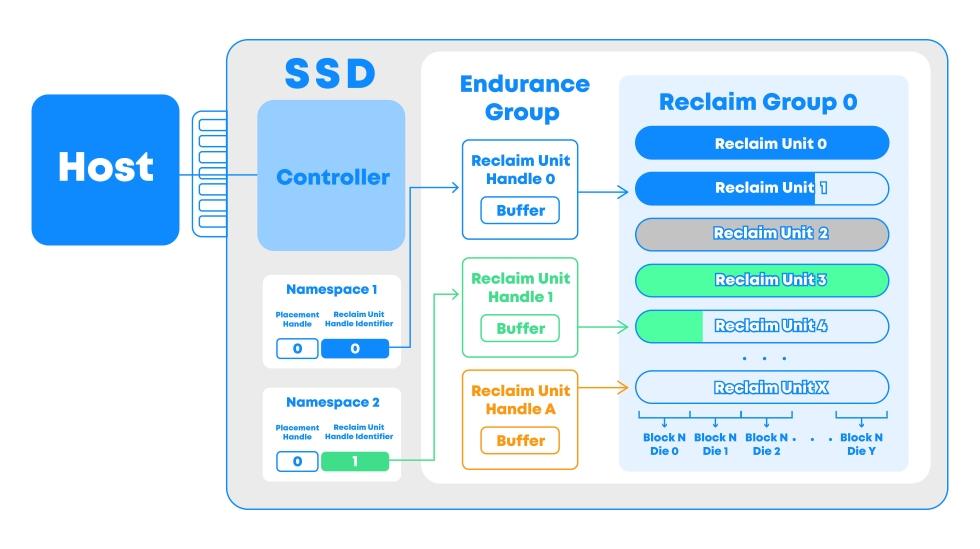

Le modèle FDP s’articule autour des Reclaim Units (RU), des Reclam Groups (RG) et des Reclaim Unit Handles (RUH). Une RU est une unité effaçable physiquement indépendante ; plusieurs RU constituent un RG.

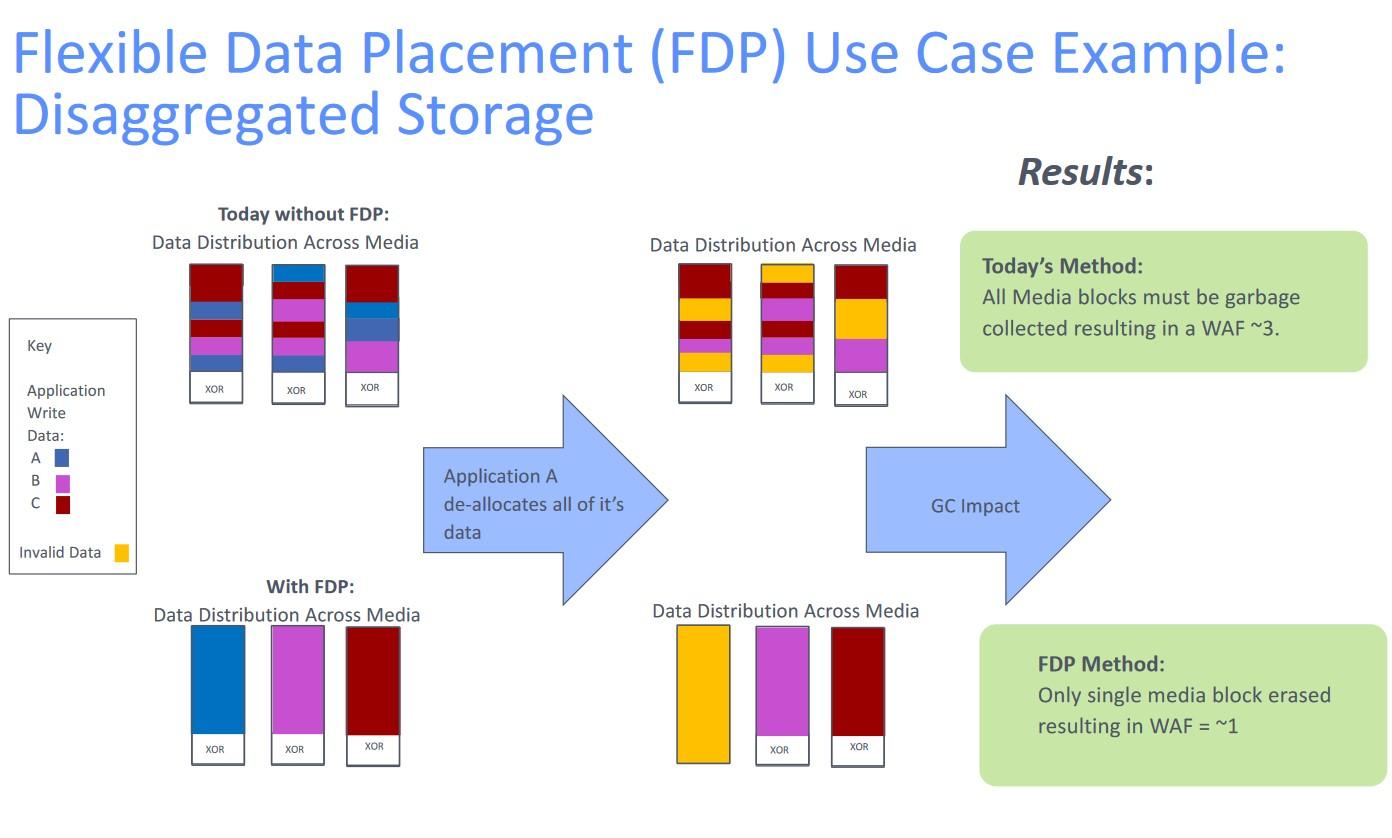

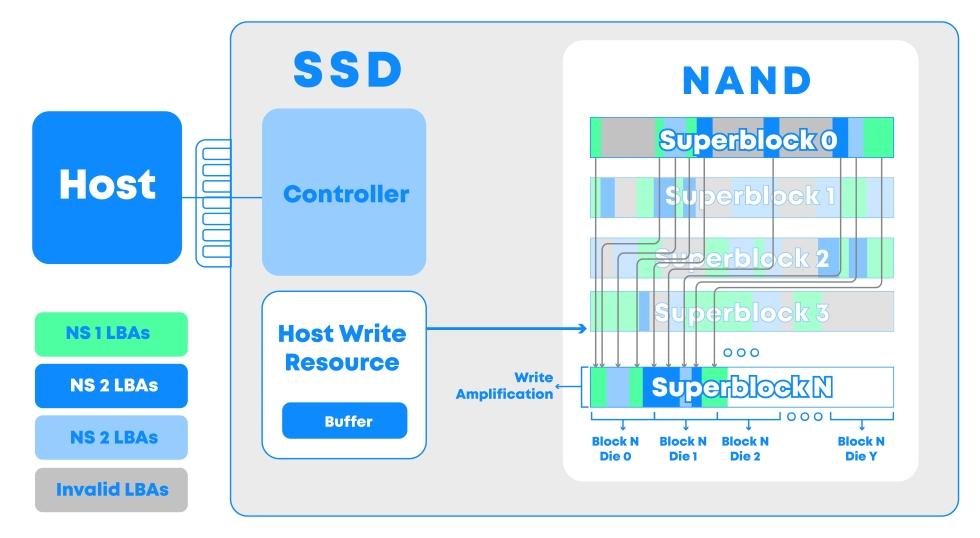

Dans les grandes lignes, l’article explique que sur des disques SSD non-FDP, lorsque plusieurs données d'application sont écrites en même temps, différentes données peuvent être mélangées sur le même super-block et chaque donnée d'application est alors dispersée sur différentes NAND. Parallèlement, les données d'application supprimées créent des fragments sur le super-bloc. Afin de réutiliser cet espace, les disques SSD non-FDP doivent effectuer une GB (Garbage Collection) pour déplacer les données valides sur le super-block. Ce déplacement explique le niveau élevé de WAF sur de tels SSD.

La WAF d'un SSD qualifié de "non-FDP"

Or, si les données des différentes applications sont écrites dans des espaces physiques distincts, lors de la suppression des données d'une application, seul l'espace physique pertinent de l'application doit être effacé et récupéré, ce qui réduit considérablement la quantité de données à déplacer par le GC. Le modèle FDP est basé sur ce principe, réduisant ainsi la WAF.

Celle d'un SSD FDP

Matt Kim, vice-président de l'activité stockage chez Marvell, s’enthousiasme : « Marvell se réjouit d'étendre sa relation de longue date avec DapuStor en mettant sur le marché des technologies de stockage innovantes. Notre collaboration sur la technologie FDP permettra d'exploiter pleinement le potentiel des disques SSD QLC, offrant ainsi à nos clients des solutions de stockage plus performantes et de plus grande capacité, pour un coût total de possession réduit ». Quant à John Li, vice-président de DapuStor, il se dit « ravi de collaborer avec Marvell pour développer des solutions FDP ».

À propos de DapuStor Corporation, l’entreprise a été fondée en avril 2016. Elle revendique plus de 400 collaborateurs au sein d'équipes de R&D réparties dans plusieurs pays.

| Un poil avant ?Ampere anticipe des processeurs Arm 256 cœurs et 512 cœurs | Un peu plus tard ...NVIDIA mitonne une carte graphique RTX 30 affublée d’un GPU Ada Lovelace (MAJ) |  |