RTX 3080 12 Go ASUS en test, bien ou inutile ? |

————— 19 Février 2022 à 14h42 —— 20173 vues

RTX 3080 12 Go ASUS en test, bien ou inutile ? |

————— 19 Février 2022 à 14h42 —— 20173 vues

NVIDIA avait lancé, à la surprise générale et presque dans l'indifférence, la RTX 3080 12 Go, qui s'est révélée être une carte exclusivement distribuée par les partenaires, pas de Founders Edition. Au menu, un léger refresh, avec 256 cuda cores de plus, et 12 Go de GDDR6X à 19 Gbps, mais sur bus 384-bit. C'est donc une carte avec un petit peu plus de VRAM, et une meilleure bande passante, de 760 à 912 Go/s. Elle est donc à mi-chemin de la RTX 3080 10 Go et de la RTX 3080 Ti, cette dernière ayant quasiment autant de cuda cores que la RTX 3090. Que vaut cette carte en pratique ?

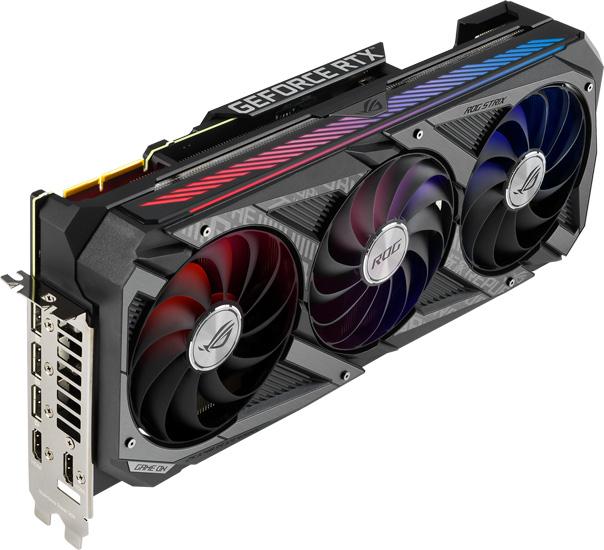

Si vous êtes déjà équipés en RTX 3080 ou 3080 Ti, il est évident que vous n'êtes pas concernés. Si vous en cherchez une, alors vous pouvez considérer la chose. TPU a fait le test du modèle ASUS Strix. La carte arbore le refroidisseur maison, et équipe la carte de 3 prises PCIe 8 pins. Niveau performances, la RTX 3080 12 Go a tendance à bien se détacher de la RTX 3080 10 Go à partir de l'UHD, et c'est variable selon les moteurs 3D. Certains seront friands de BP supplémentaire, d'autres n'en auront cure. Pour autant, il est compliqué d'apprécier le gain, c'est-à-dire de savoir d'où provient le gain. La carte a été comparée à une RTX 3080 et 3080 Ti FE, et nous ne saurons dire si les performances proviennent réellement de la bande passante, ou du fait qu'avec un TDP lâché, la carte pousse sur les fréquences. C'est probablement un peu des deux au final, mais dans quelles proportions ?

Les cartes ont bien baissé dans le commerce, c'est évident. Si vous pouvez temporiser, continuez, car c'est trop cher encore. Si vous ne le pouvez plus, alors regardez bien les tests, car il y a du stock et de l'offre désormais.

| Un poil avant ?Voici la roadmap de Lake d'Intel jusqu'en 2024... | Un peu plus tard ...Promopub • Signez en ligne vos documents avec Yousign.com |  |

|

C'est pas du tout des chiffres que je zape, je les trouve nécessaire tant pour l'aspect écologique que financier (surtout financié vu le prix de électricité qui continue de flambé d'année en années).

Si je devais changé de CPU, avec mon profil de joueur exclusivement, je partirais du coup vers un 12600 ou un 5600 pour l'instant. Je doute pas que les cpu au dessus fasse (et feront à l'avenir...) mieux, mais la consommation à un coût !