Vous souhaitez un PC IA haut de gamme ? Achetez une GeForce ! |

————— 02 Mai 2024 à 16h24 —— 25631 vues

Vous souhaitez un PC IA haut de gamme ? Achetez une GeForce ! |

————— 02 Mai 2024 à 16h24 —— 25631 vues

Cela ne vous aura pas échappé, le nouveau terrain de bataille entre AMD et Intel porte sur l’intelligence artificielle, avec l’intégration de NPU (Neural Processing Unit) au sein des processeurs. L’entreprise dirigée par Lisa Su en intègre à certains Ryzen depuis les Ryzen 7000 mobiles Phoenix – y compris aux Ryzen 8000 Embedded – tandis qu’Intel s’est lancé avec Meteor Lake. Ce ne sont bien sûr que les préliminaires, et il faut s’attendre à une orgie d’IA dorénavant, avec la promesse de nouvelles générations offrant une débauche de TOPS (Trillions or Tera Operations per Second) ; l’obscure valeur choisie par les marques impliquées pour se distinguer de leurs rivales dans ce jeu de séduction on ne peut plus contemporain, mais qui ne se résume finalement qu'à revendiquer le plus gros TOPS.

Et NVIDIA dans tout ça ? La société dirigée par Jensen Huang ne vend pas encore de processeurs grand public ; elle semble donc condamner à faire son affaire dans son coin, c’est-à-dire dans le secteur du HPC ; à se contenter d’accumuler les milliards en capitalisation boursière et de vendre ses accélérateurs IA à foison. Que nenni ! NVIDIA commercialise des moteurs IA auprès du grand public depuis belle lurette avec ses GeForce RTX, cartes graphiques munies de cœurs Tensor. Jusqu’ici, ils servaient principalement à la prise en charge matérielle du DLSS (Deep Learning Super Sampling), mais peuvent tout à fait accélérer d'autres fonctionnalités IA ; d’ailleurs, ce sont bien des cGPU qui s’en chargent dans les supercalculateurs. À travers quelques diapositives, NVIDIA a remis un peu les pendules à l’heure en rappelant la supériorité des GPU par rapport aux NPU actuels intégrés aux processeurs.

NVIDIA ACE © Benchlife

Comme rapporté ci-dessus, NVIDIA n’a pas attendu 2024 pour se mettre à l’IA. Le DLSS, inauguré en 2018 par la génération Turing (RTX 20 Series), est une technologie de mise à l’échelle dopée à l’intelligence artificielle. L’arsenal de l’entreprise en la matière ne s’arrête pas là : mentionnons le RTX Video Super Resolution, le RTX Video HDR qui rend plein de jeux compatibles HDR, ou encore le tout récent Chat with RTX, un assistant local.

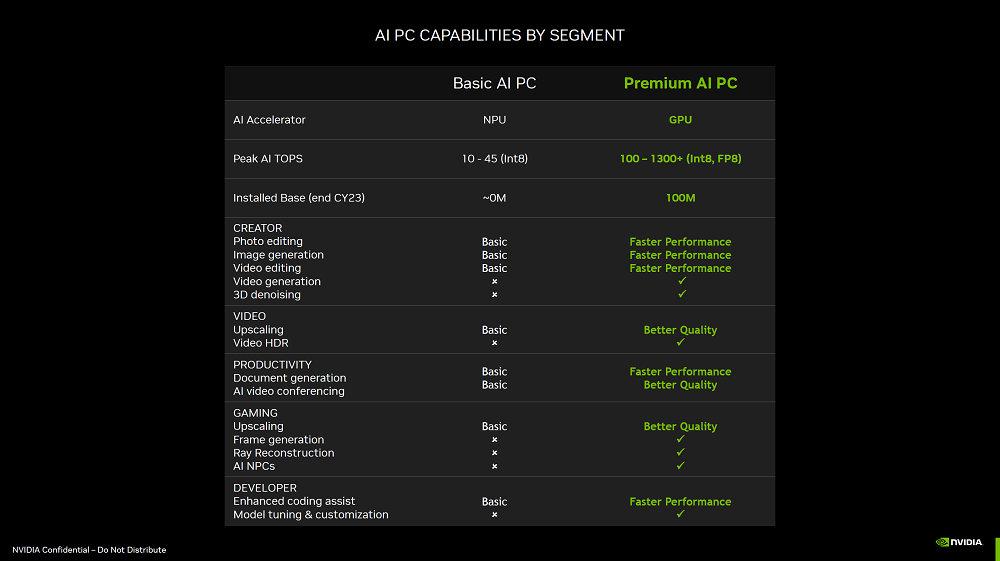

Dans les images publiées par le site Benchlife, NVIDIA met ainsi en avant la puissance de calcul des GPU, laquelle est bien supérieure à celle des NPU pour l’Int8 : les seconds plafonnent actuellement de 10 à 45 TOPS (pour le NPU pur ; cette puissance est amenée à augmenter d’un facteur 2 ou 3 dès la prochaine génération de Core / Ryzen), tandis que les cartes graphiques fournissent entre 100 et 1300 TOPS. En outre, l’entreprise relève que le parc actuel comprend plus de 100 millions de PC armés d’un GPU capable de gérer l’IA, contre moins d’un million de machines dotées de NPU fin 2023.

Victoire par K.O pour les GPU © Benchlife

NVIDIA liste ensuite différentes technologies accessibles aux GPU mais encore pas encore gérées par les NPU, telles que la FR (Frame Generation – génération d’images) ou encore les AI NPCs : des personnages non jouables stimulés par l’IA prometteurs, mais encore expérimentaux.

Difficile de donner tort à NVIDIA sur le constat. Après, les NPU se destinent, pour l’instant, surtout à être intégrés au sein de processeurs portables dépourvus de GPU dédié. De plus, ce ne sont que les débuts de l’intégration de tels accélérateurs dans les PC ; la comparaison avec les GPU est donc forcément biaisée. Et ne parlons pas des écarts de prix...

Oui, mais le prix d'une RTX 4090 dans tout ça ? © Benchlife

Ces diapositives ont été présentées dans le cadre d’un évènement avec la presse. Il est probable que NVIDIA nous les resserve lors du Computex.

Quoi qu’il en soit, au-delà des arguments mis en avant par Intel, NVIDIA et AMD pour promouvoir leurs propres solutions respectives, nous sommes vraisemblablement à un tournant de l’informatique grand public. L’un de ses pionniers, Bill Gates, considère que l’IA va totalement transformer la manière dont nous utilisons des ordinateurs au cours des prochaines années – une révolution similaire à celle induite par la généralisation des interfaces graphiques.

Comment l’intelligence artificielle va-t-elle changer notre façon de consommer l'informatique ? En remodelant nos interactions avec celle-ci via un nouvel intermédiaire, le fameux assistant personnel intelligent, au premier rang desquels trône Copilot, celui de Microsoft. Il est envisageable que cet assistant devienne notre principal interlocuteur et qu'il parachève la simplification amorcée il y a quelques décennies : il suffira de dialoguer avec lui pour qu’il effectue des tâches qui nécessitaient, jusqu’ici, certaines capacités et connaissances : générer une image, rédiger un texte, résumer un document, répondre à un mail, etc. Bien sûr, outre ces facultés, cet assistant sera en mesure de s’adapter à chaque utilisateur, d’identifier ses besoins, afin de soumettre lui-même des suggestions – avec toutes les implications relatives au respect de la vie privée, voire d'une forme d'enfermement intellectuel, qu’une telle appréhension suscite.

Il sera de toute façon difficile d’y échapper, tant les acteurs du secteur semblent marcher main dans la main pour orienter les consommateurs vers cette destination. C’est le cas de Microsoft, qui prépare un Windows 24H2 faisant la part belle à l’IA (sans doute en guise d’avant-goût à Windows 12), mais aussi d’Intel, AMD, Qualcomm et désormais NVIDIA, qui soutiennent cette évolution – dans leurs propres intérêts, cela va de soi. Déjà, Intel fait miroiter des Lunar Lake offrant 100 TOPS de performances IA, tandis que même pour sa fête d’anniversaire, AMD n’a pu s’empêcher de faire joujou avec, et Lisa Su de vanter les mérites des prochains Ryzen sous architecture NPU XDNA 2 lors de la présentation des résultats financiers.

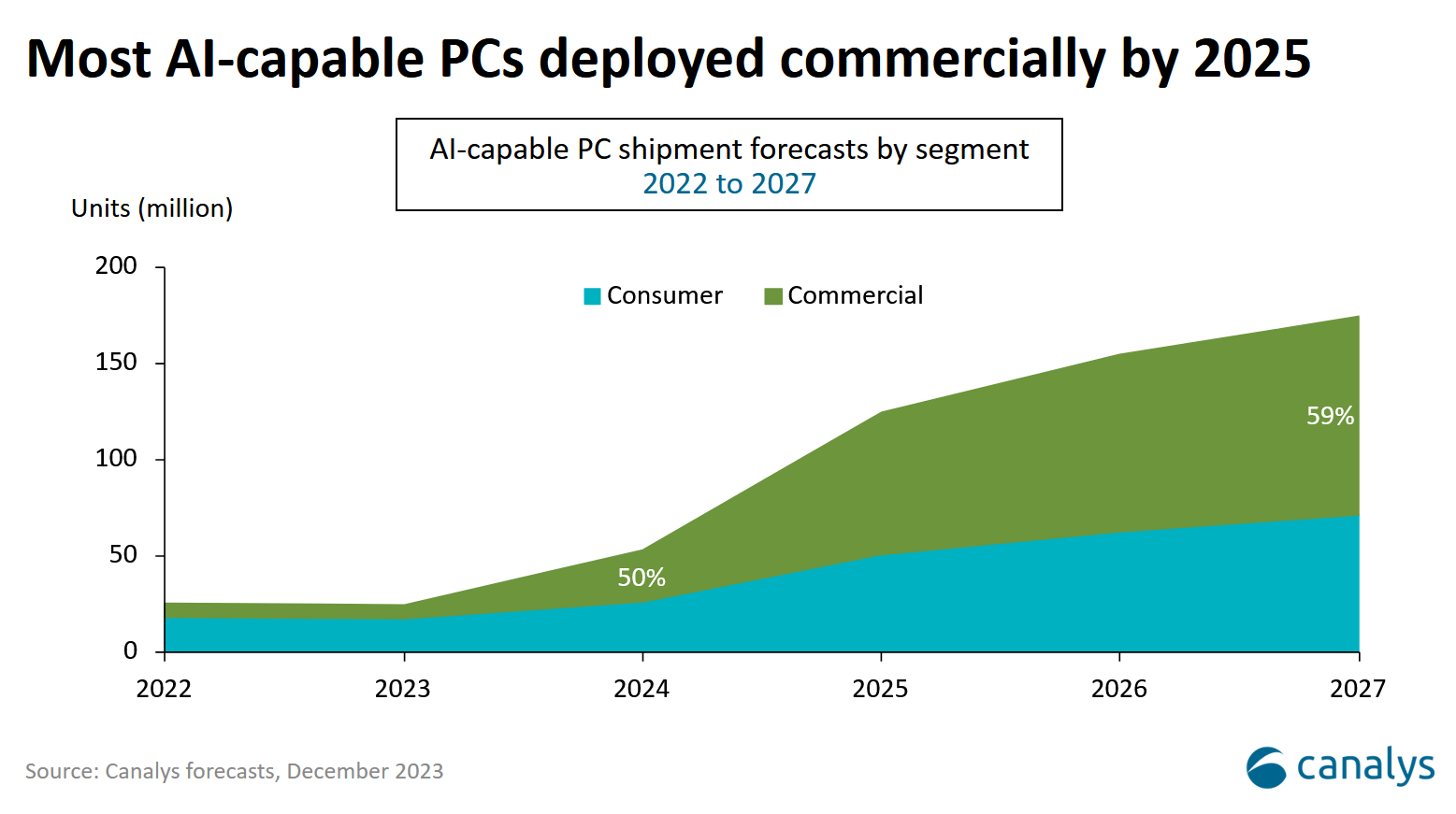

La société d’analyse Canalys entrevoit ainsi une hausse progressive des ventes de « PC IA » au fil des années. Le cabinet « prévoit que 60 % des PC livrés d'ici 2027 » seront de cette espèce, « ce qui met en évidence un changement significatif dans le paysage technologique ».

© Canalys