Les fréquences élevées des Core Raptor Lake à l'origine de plantages dans certains jeux ? |

————— 29 Mars 2024 à 19h04 —— 48124 vues

Les fréquences élevées des Core Raptor Lake à l'origine de plantages dans certains jeux ? |

————— 29 Mars 2024 à 19h04 —— 48124 vues

Les Core i9 de 13e et 14e générations comptent parmi les meilleurs processeurs pour jouer. Outre leur armada de cœurs CPU, ces Core i9-13900K et autres Core i9-14900K atteignent des fréquences aberrantes : jusqu’à 6,2 GHz pour le Core i9-14900KS. Seulement des rapports les accusent d'être la source de plantages dans certains titres.

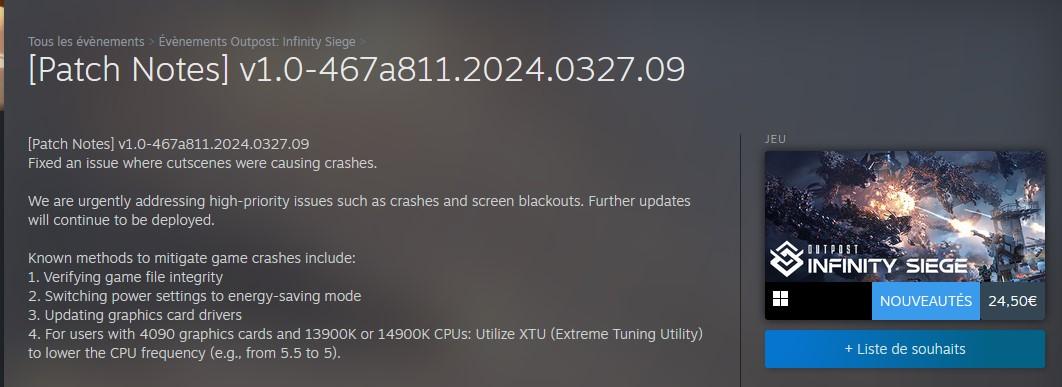

Cette affaire agite certains internautes depuis plusieurs semaines, mais vient d’être ravivée par les déclarations des développeurs d'Outpost : Infinity Siege. C’est un jeu développé par Team Ranger qui est paru le 26 mars dernier. À l’instar d’autres productions, comme Star Wars Jedi : Survivor – dont les développeurs avaient d’ailleurs présenté leurs excuses – ce soft est très mal optimisé. Dans les notes d’un patch censé corriger certaines sources de plantages, les membres de la Team Ranger font quelques recommandations habituelles, telles que vérifier l’intégralité des fichiers du jeu ou mettre à jour ses pilotes graphiques. La dernière est toutefois moins usuelle : elle invite les possesseurs de Core i9-13900K et de Core i9-14900K à limiter les fréquences du CPU lorsque celui-ci collabore avec une GeForce RTX 4090 (on se demande tout de même ce que la carte graphique de NVIDIA vient faire ici).

De prime abord, cette directive peut paraître assez farfelue ; une excuse bidon servant à se dédouaner, en somme. Seulement tel que rapporté en début d’article, les deux accusés sont suspectés depuis plusieurs mois.

Notre confrère Jarred Walton, par exemple, confesse avoir subi de nombreuses instabilités lors de ses tests GPU avec le Raptor Lake. Parmi les titres problématiques, il cite Alan Wake 2, Hogwarts Legacy, ou encore Metro Exodus Enhanced Edition.

Dans un article consacré à ce sujet et publié le 23 février dernier, TH.US précise ainsi « qu’un nombre croissant d'utilisateurs des Core i9-13900K et Core i7-13700K ont signalé des plantages dans certains des jeux les plus récents, généralement accompagnés d'une erreur de mémoire vidéo insuffisante ». Outre Jarred Walton, Hassan Mujtaba de WCCFTech a indiqué, en réponse à une publication d’un certain Sebastian Castellanos incriminant globalement les jeux sous Unreal Engine 4 et 5, avoir lui aussi été confronté à ces désagréments.

Seeing a worrying trend with some Intel 13th/14th gen CPUs having stability issues with UE4/UE5 games (like Fortnite, Remnant 2, Hogwarts Legacy etc.) specifically during the initial shader comp process, which apparently exposes "bad CPUs" and requires an underclock to stabilize: pic.twitter.com/0Qse0azI1r

— Sebastian Castellanos (@Sebasti66855537) February 20, 2024

Contactée par nos confrères, Intel avait répondu : « Intel est au courant des rapports concernant les processeurs d'ordinateur de bureau Intel Core 13e et 14e Génération non verrouillés qui rencontrent des problèmes avec certaines charges de travail. Nous sommes en contact avec nos partenaires et nous analysons les problèmes signalés ». La société n'a rien ajouté depuis.

Sur Steam, un dénommé MrPlowjoy documente son message des préconisations formulées par deux autres développeurs : Fatshark, à qui l’on doit notamment Warhammer: Vermintide 2 et Warhammer 40,000: Darktide, mais aussi Gunfire Games, le studio derrière Remnant II / Remnant I.

Sur le site du premier, nous pouvons lire :

« Intel i9 13900k/i7 13700k : Underclocker la vitesse du 'Performance Core' (cœur de performance) : Il a été noté que les joueurs équipés du processeur Intel i9 13900k/i7 13700k sont sujets à des plantages. Les joueurs ont pu contourner le problème en sous-cadençant la vitesse du "Performance Core" à l'aide d'Intel XTU, de x55 à x53. »

Sur celui du second :

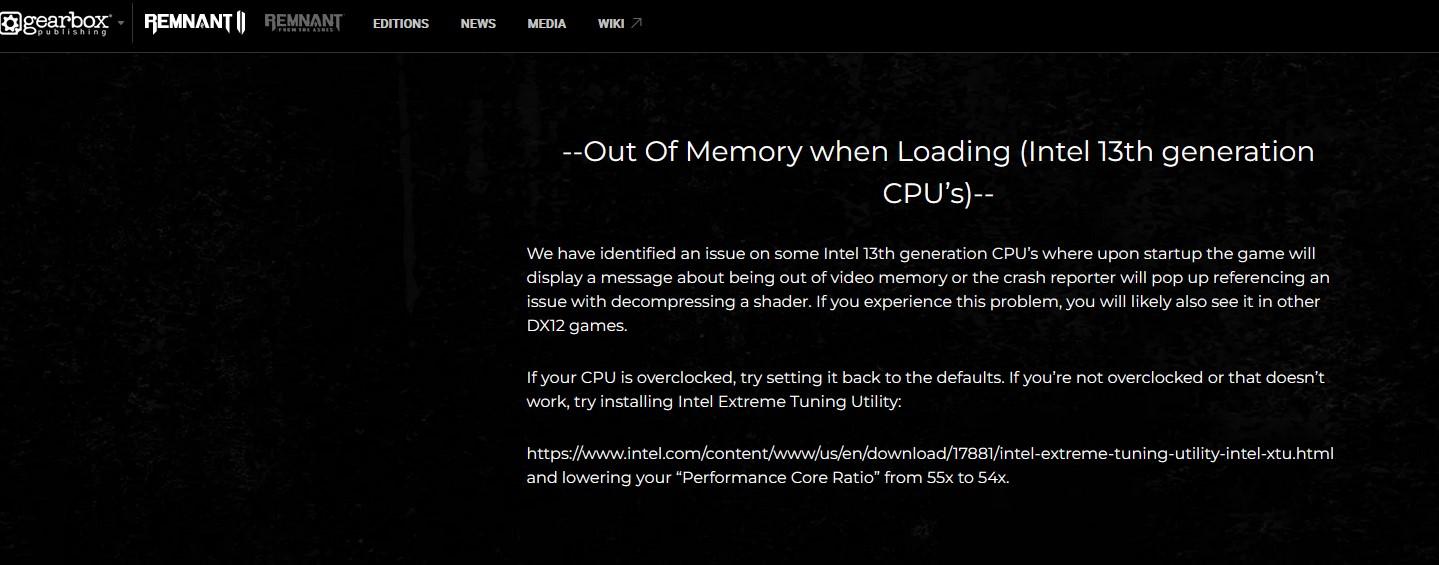

« Nous avons identifié un problème sur certains processeurs Intel de 13ème génération. Au démarrage, le jeu affiche un message indiquant qu'il n'y a plus de mémoire vidéo ou un rapport de crash s'affiche, faisant référence à un problème de décompression d'un shader. Si vous rencontrez ce problème, vous le verrez probablement aussi dans d'autres jeux DX12. Si votre processeur est overclocké, essayez de revenir aux valeurs par défaut. S'il n'est pas overclocké ou si cette méthode ne fonctionne pas, essayez d'installer Intel Extreme Tuning Utility

et de réduire votre "Performance Core Ratio" de 55x à 54x. »

Selon notre confrère de TH.US, le souci vient des limites fixées par défaut par la plupart des cartes mères pour les processeurs Raptor Lake : 4096 W. Il argue que cela peut « conduire à l'instabilité de l'application dans certains cas, en fonction de la qualité du silicium ». Une manière polie de dire qu’Intel commercialise des puces qui ne sont pas en mesure d’encaisser les fréquences que l'entreprise a elle-même fixées ?

| Un poil avant ?MSI Spatium M580 FROZR, le SSD qui se prenait pour un GPU | Un peu plus tard ...La NAND continue à faire le yoyo : 15 % de hausse sur les SSD au 2e trimestre |  |