La standardisation du L4S avance, ou comment l'internet de demain pourrait être nettement décongestionné |

————— 14 Décembre 2023 à 15h45 —— 91861 vues

La standardisation du L4S avance, ou comment l'internet de demain pourrait être nettement décongestionné |

————— 14 Décembre 2023 à 15h45 —— 91861 vues

Hop, parlons un peu des internets. Si le déploiement de l'ultra haut débit, enjeu clé du développement numérique des territoires, continue sa progression dans nos belles contrées — bien qu'un poil humides ces derniers temps — la rapidité du tuyau qui est mis à disposition ne rime pas nécessairement toujours avec une expérience à la hauteur. En moyenne en novembre 2023, un très haut débit par fibre permet aux alentours d'atteindre les 350 Mbit/s — un chiffre en augmentation, plutôt éloigné des promesses des opérateurs — soit trèèès largement de quoi visiter le oueb à des vitesses qui ne manquent jamais de faire pleurer ceux qui ont connu le 56k voire même le xDSL plafonnant à 2 Mbit/s. On parle de fibre, mais cette observation vaut aussi pour l'ensemble des normes offrant de gros tuyaux de transfert, comme la 5G... qui pourtant dans un paquet de cas ne fait guère mieux que la 4G.

Mais voilà, la taille du tuyau, ça ne fait pas tout. Les latences — le temps nécessaire au transfert des données aller/retour entre un client et un serveur —, vous le savez pour ceux qui jouent en ligne, sont au cœur de la réactivité de vos diverses expériences sur la toile. Ce sont elles qui induisent, ou non, le lag dans les jeux — les gens confondent souvent ce terme avec les latences d'affichages, ce sont pourtant deux choses différentes, même si dans certains cas un lag réseau peut induire un retard de l'affichage — mais également peuvent provoquer certaines saccades au cours de visionnages en streaming, en dépit d'avoir une capacité stratosphérique en débit.

C'est le genre de truc qu'on essaye de vous vendre sur des routeurs « gaming » prétendument aptes à faire fondre ces fameuses latences, alors qu'en début ou en bout de chaine ils n'y peuvent au final pas grand-chose seuls. Parcequ'internet, ce n'est pas vous + un serveur, mais vous + une multitude de serveurs et de commutateurs interconnectés, des interconnections qui peuvent chacune occasionner des échanges (eh oui, Internet est un lieu d'échangisme géant) et donc... des délais dans ces échanges.

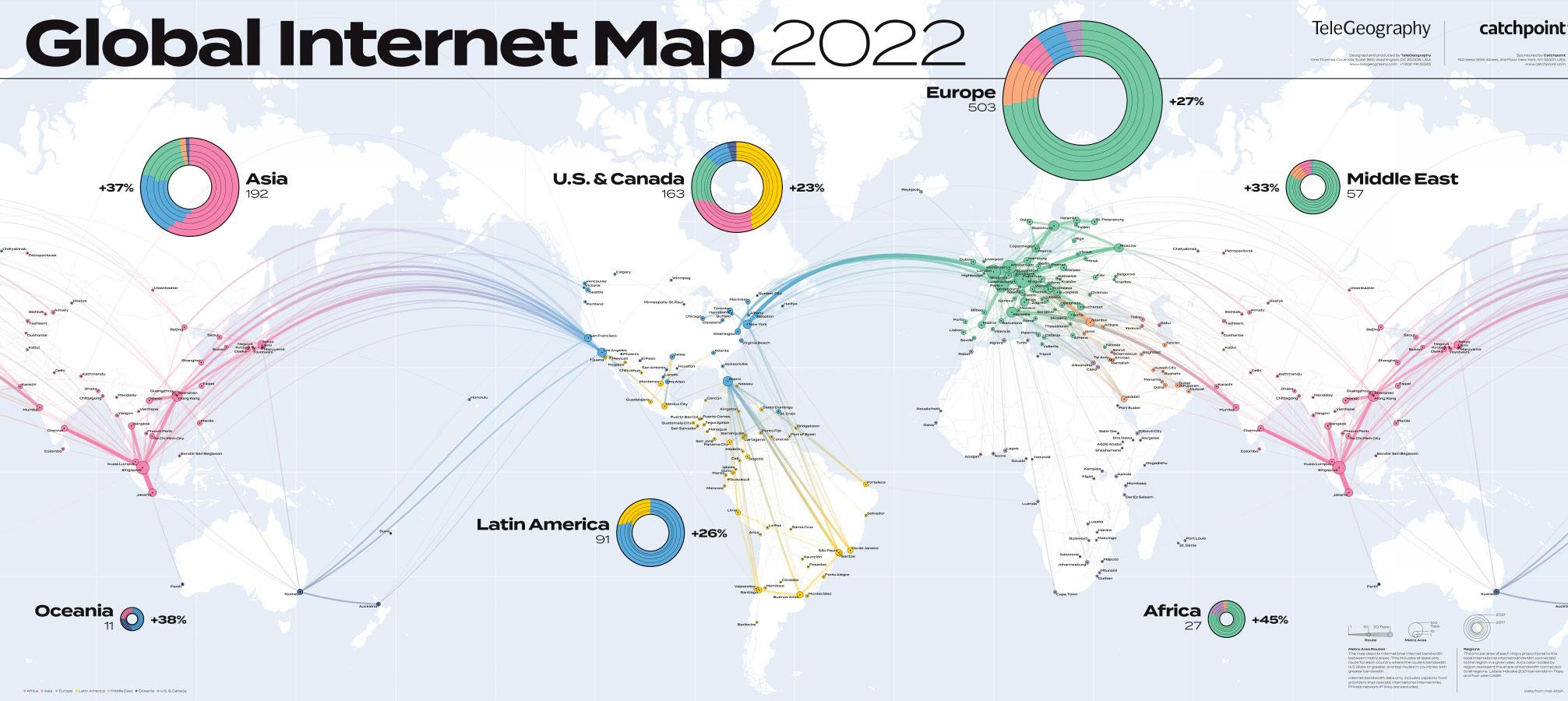

À voir en plus grand chez telegeography.com

Les goulots d'étranglement, compte tenu du maillage assez infernal que peut représenter le web (vous êtes-vous déjà imaginé le bouzin ?), sont de faits nombreux chaque machine ou point d'échange disposant de capacités propres et éventuellement d'un taux d'occupation. Parmi ceux-ci, on compte le fameux phénomène du bufferbloat. À la manière d'un tronçon d'autoroute saturé de voitures qui inévitablement bouchonne et en rend dingue ses victimes, internet de part l'évolution des échanges a du s'adapter afin de contrer les soucis de congestion réseau.

Et pour cela, quoi de mieux que des zones tampons — les buffers — pour stocker les paquets échangés en attendant leur traitement. Le problème étant que si les tampons arrivent à saturation, les paquets sont tout simplement supprimés et doivent être renvoyés par le client expéditeur : de quoi entrainer un sur-traffic et si par malheur plusieurs clients font la même chose, c'est la congestion assurée : c'est le principe de base du DDoS.

L'une des mesures pour éviter cela : une réduction du trafic, mais une réduction intelligente. On parle de démarrage lent, où on commence par envoyer un paquet IP à un serveur, puis quand celui-ci a répondu normalement on en envoie deux, et ainsi de suite jusqu'à une comportement anormal — perte de paquets, délais... — dans la réponse qui signifiera avoir trouvé la bonne vitesse de négociation des données entre les deux protagonistes et leurs intermédiaires. S'en suit ensuite des algorithmes TCP visant à stabiliser les échanges. Ces deux étapes sont facilement observables lorsque vous lancez des téléchargements plus ou moins lourds : au début ils commencent doucement, puis au bout d'un — normalement court — moment, on observe une alternance entre le débit maximal de crète et une fenêtre de transfert un peu moins pêchue résultant de pertes de paquets réseaux et de la renégociation qui s'en suit, ce qui se traduit sur les monitoring de débits par une courbe en dents de scie.

![Cliquédélique ! traffic internet - cas de démarrage lent sur steam [cliquer pour agrandir]](/images/stories/_reseaux/traffic-internet-demarrage-lent-steam_t.jpg)

Un cas de démarrage lent (oui... tout est relatif) et de renégociation côté client

Ce sont ces mécaniques, ô combien salvatrices pour le net mondial, qui occasionnent le bufferbloat : le flux essayant de négocier la meilleure vitesse possible travaille avec des paquets qui sont encore en zone tampon, qui devenus trop massifs avec le temps mettent du temps à se remplir avant traitement ; la latence aller-retour augmente au fur et à mesure que la zone tampon se remplit, pouvant atteindre plusieurs secondes. En dépit de solutions pour pallier cela telles que le QoS, le contrôle de congestion reste une problématique globale à l'échelle du réseau des réseaux.

![Si vous cliquez, vous cliquez. mesure RRUL sans bufferbloat [cliquer pour agrandir]](/images/stories/_reseaux/rrul_graph_sans_bufferbloat_t.png)

![Si vous cliquez, vous cliquez. mesure RRUL avec bufferbloat [cliquer pour agrandir]](/images/stories/_reseaux/rrul_graph_avec_bufferbloat_t.png)

Le bufferbloat par l'exemple (à gauche sans, à droite avec) , via flent.

On comprend dès lors que, là encore, le marketing des fournisseurs d'accès fait son œuvre et vous vend une capacité de transfert, et non pas une vitesse de transfert. Et en plus il vous vendent ça en bits/secondes, histoire de poser des chiffres nettement plus vendeurs ; pensez donc, 1 Gbit/s c'est quand même vachement mieux que 125 Mo/s, surtout pour regarder plus belle la vie en UHD upscalée, cette 9e symphonie des séries de merde.

Bon sur ce dernier point de la normalisation en Gbps, c'est une friponnerie qu'il faut attribuer à l'industrie entière, pas spécifiquement aux FAIs. Bref, vous pouvez avoir un connexion Livebox 7 de-dernière-génération-qui-tue-et-qui-en-plus-est-recyclable à 5 Gbit/s, ou un réseau full Wi-Fi 7 qui coûte le prix d'un deux roues, si vous avez des latences de plusieurs dizaines de ms se répétant plusieurs fois dans vos échanges de données, votre expérience sera quand même moisie.

C'est la coqueluche des mastodontes de l'industrie de web. He oui, dans la vie en 2023, il n'y pas que l'IA : il y aussi... Les moyens pour y accéder ! Low Latency, Low Loss, Scalable Throughput, voila ce que signifie l'acronyme pour la norme L4S. Il s'agit bien là d'un contrôle de diarrhée congestion réseau, mais visant à optimiser les débits sans en sacrifier les latences. Pour cela, le L4S ambitionne de vous responsabiliser — en tout cas, vos appareils — de manière à balancer moins de watts (= envoyer moins de paquets) lorsqu'un cas de congestion est détecté, c'est-à-dire anticiper le phénomène avant qu'il ne devienne trop important et occasionne des dysfonctionnements du réseau. Le problème est ainsi traité à la source de la chaine de transfert, limitant de fait les latences résultantes des soucis de congestion.

Pour cela, on place une balance un marqueur directement dans l'en tête des paquets IP permettant aux dispositifs prenant part aux échanges client/serveur d'identifier rapidement une zone de congestion et d'envoyer un ordre pour agir en conséquence, le paquet étant marqué comme congestionné, l'ordre se répercute sur tout le chemin matériel des échanges et l'expéditeur ainsi informé peut réduire rapidement son taux d'envoi en conséquence : de facto le process devient bien plus réactif. On parle des algorithmes Prague.

Autre point notable, la capacité du L4S dans la hiérachisation des paquet via la gestion active des files d'attente, autrement dit un paquet marqué comme étant prioritaire obtient la garantie de traitement rapide : oui, c'est du QoS.

Les premiers essais de traffic L4S grandeur nature ont été plutôt concluants, diminuant les latences mesurées sur un facteur de 10.

Résultante : réseaux réactifs & débits optimisés, perte de paquets quasi nulle, de quoi passer vos conf calls vidéo sans bouillies de pixels ponctuelles, réouvrir la voie à toutes sortes de services a qui le lag nuit grandement, ou tout simplement surfer parfois nettement plus rapidement.

Les négociations, ça reste la base, même sous L4S

Cette solution qui finalement n'est qu'une évolution des protocoles d'échanges sans être une révolution de ces derniers peut paraitre simple dans sa mise en place. C'est sans compter sur le fait que nous sommes à l'échelle du réseau mondial : l'ensemble des équipements réseau doivent être rendus compatibles, tout comme les OS, même si L4S reste rétro compatible. Son adoption optimale prendra ainsi probablement plusieurs années. Tout l'enjeu sera donc une sorte de mise à jour globale devant être immiscée par les GAFAM, ce que Google ou Apple sont bien partis à faire, les équipementiers quant à eux s'activent déjà sur le sujet. Si en plus on met un point d'arrêt au flux vidéos dégeulasses qu'ils soient publicitaires — vous savez, les pop-ups bien pénibles qui s'invitent sur les pages que vous visitez — ou issus de créateurs de contenus toujours bien intentionnés, on aura franchi un grand pas pour désengorger le réseau de choses inutiles !